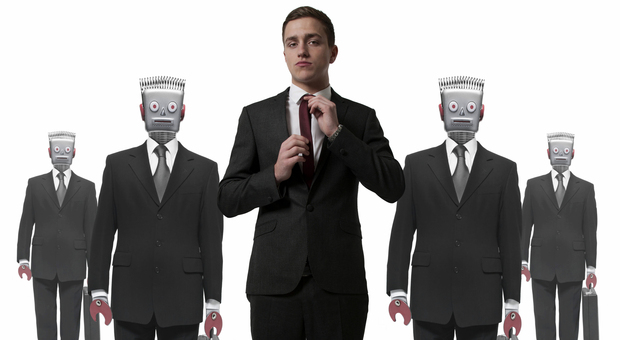

Frank Pasquale è una voce importante, riconosciuta a livello internazionale, e precursore nella delicata materia della regolamentazione delle nuove tecnologie. La casa editrice Luiss University Press ha appena pubblicato in Italia il testo fondamentale del professore della Brooklyn Law School. “Le nuove leggi della robotica” (traduzione di Paolo Bassotti, 322 pagine, 20 euro) fin dal sottotitolo rivela la propria intenzione: difendere la competenza umana nell’era dell’intelligenza artificiale. Pasquale affronta le questioni più calde, dall’impatto dell’automazione nel mondo del lavoro ai problemi etici posti dai robot. Il saggio anticipa le sfide del prossimo decennio, proponendo confini concreti per non subire gli effetti di una crescita sregolata.

Perché ha scelto di aprire l’introduzione del libro con le leggi della robotica di Isaac Asimov?

«La sua influenza è stata enorme, coinvolgendo di fatto i robot nel nostro mondo. Le tre leggi di Asimov pongono le questioni dell’interazione tra l’uomo, la macchina e rivelano le ambiguità poste dalla crescita della robotica e dell’intelligenza artificiale. Lui immaginava come i robot potessero rendere le nostre vite migliori. Ora mi preoccupo del loro potere e interrogo sul come porci in controllo dello sviluppo tecnologico».

Qual è la base delle leggi fondamentali che propone?

«I sistemi robotici e le AI devono essere complementari e non sostituire i professionisti. L’insegnamento, la medicina, il giornalismo come altre professioni richiedono livelli di competenza anche emozionale da non poter essere soppiantati».

Un esempio?

«Lo scopo della tecnologia non può essere creare un robot medico o infermiere, così come non si può delegare la prescrizione di farmaci. Servono invece figure che sappiano mediare tra i clienti e la tecnologia».

Lo sviluppo dell’intelligenza artificiale è fuori controllo?

«Il problema reale è il fallimento nell’autoregolamentazione, dunque è necessario intervenire».

Che cosa intende quando descrive il rischio di contraffazione del fattore umano?

«I robot umanoidi ci affascinano. I programmi di machine learning sono già in grado di creare immagini di persone finte e mi preoccupa la diffusione di voci sintetiche. Vorrei continuare a sapere se mi rapporto con una macchina o a un essere umano. Gli stessi software di assistenza virtuale devono essere ben riconoscibili per evitare frodi anche economiche».

Qual è il fronte normativo?

«Ho una posizione radicale. Perché dobbiamo progettare robot umanoidi? Dall’imitazione alla sostituzione il lasso di tempo potrebbe essere molto breve. La contraffazione dell’umanità altera l’interazione fondamentale tra aziende, governi e cittadini».

Come sintetizzerebbe il confine tra l’umanità e l’intelligenza artificiale?

«Quest’ultima può aiutare i genitori, non esserlo».

Lei sembra considerare l’impatto sul lavoro non soltanto per sottrazione.

«Esattamente. La robotica e le AI provocheranno un aumento costante delle competenze e dei settori di applicazione, tale da rendere necessaria una sempre più ampia gamma di professionalità per capitalizzare le opportunità date dalle nuove tecnologie».

Tra i suoi campi di osservazione ci sono in particolare la medicina, la giustizia e l’informazione. Quale avrà una maggiore trasformazione?

«Per anni ho analizzato il settore giudiziario e la ricaduta dell’automazione. Questo ambito, come quello medico, ha maggiori protezioni all’interno delle proprie strutture professionali, perché la posta è alta. Per il giornalismo sarebbe altrettanto, ma è meno protetto. Rischiamo di delegare l’indirizzo dell’informazione ai grandi numeri con una sorta di esternalizzazione della nostra mente a ciò che viene canalizzato».

Dedica molte pagine alla questione etica e tecnologica degli arsenali militari. Che cosa occorre fermare?

«La corsa degli Stati agli armamenti non rallenta mai. È la terza legge che propongo e si contestualizza in un ampio movimento globale e nel dibattito del diritto internazionale sui cosiddetti robot killer. Lo sviluppo dei “sistemi di armi letali autonome” è una frontiera pericolosa».

Che cosa significa la trasparenza di un algoritmo?

«Rispecchia la logica dell’algoritmo tanto nella sua espressione esplicita matematica quanto nel tipo di dati utilizzati. La trasparenza riguarda le modalità di sviluppo informatico e l’analisi del comportamento dell’algoritmo una volta che viene utilizzato massivamente. La gestione del mondo dei numeri è la questione centrale delle democrazie».

È possibile immaginare delle istituzioni che regolino l’intelligenza artificiale?

«Ogni campo professionale è ormai chiamato a dotarsi di agenzie di controllo per le rispettive applicazioni, diventando un punto di riferimento oggi inesistente anche per chi lavora sull’AI. Considero dunque un approccio a più livelli governato da istituzioni che conoscano la tecnologia e sappiano accompagnarne lo sviluppo».

© RIPRODUZIONE RISERVATA